Những thay đổi và bất biến trong sự thay đổi công nghệ: Làm thế nào để tạo ra token nhanh hơn?

2024-06-02

Thời gian nào tương lai đến phụ thuộc vào tốc độ chúng ta có thể tạo ra token nhanh như thế nào.

Với sự phát triển không ngừng của trí tuệ nhân tạo thế hệ mới (GenAI)cá cược bóng đá, chúng ta đang bước vào một kỷ nguyên công nghệ hoàn toàn mới. Tuy nhiên, do quy mô tham số khổng lồ của các mô hình ngôn ngữ lớn (LLM), hiệu suất suy luận (inference) trong các hệ thống AI hiện đại trở thành một vấn đề kỹ thuật đặc biệt quan trọng. Nâng cao hiệu suất suy luận của LLM không chỉ giúp tạo ra chuỗi token nhanh hơn mà còn đồng nghĩa với việc giảm thiểu chi phí vận hành. Trong bối cảnh cạnh tranh ngày càng khốc liệt giữa các nhà cung cấp dịch vụ AI, việc tối ưu hóa hiệu suất suy luận đã trở thành một yếu tố then chốt để duy trì lợi thế thị trường. Điều này không chỉ thúc đẩy sự phát triển của các mô hình học sâu tiên tiến mà còn mở ra cơ hội cho việc ứng dụng AI rộng rãi hơn trong nhiều lĩnh vực khác nhau. Từ ngành y tế đến tài chính, từ giáo dục đến giải trí, tất cả đều đòi hỏi khả năng xử lý dữ liệu nhanh chóng và chính xác, điều mà LLM có thể đáp ứng nếu được tối ưu hóa tốt. Do đó, việc nghiên cứu và phát triển các phương pháp mới để cải thiện hiệu suất suy luận của LLM không chỉ mang lại lợi ích về mặt kỹ thuật mà còn góp phần tạo nên một tương lai bền vững hơn cho ngành công nghiệp AI nói riêng và xã hội nói chung.

Trong bài viết nàycá cược bóng đá, chúng tôi sẽ thảo luận về một số khía cạnh liên quan đến vấn đề hiệu suất dịch vụ suy luận của LLM:

- Trước tiên123win+club, từ góc nhìn bên ngoài hệ thống, nên Làm thế nào để đo lường hệ thống? Chúng ta nên quan tâm đến những chỉ số hiệu năng nào? So với hệ thống truyền thốngbầu cua, chúng có điểm gì giống và khác biệt? Câu trả lời cho câu hỏi này sẽ định hình mục tiêu thiết kế của hệ thống, đồng thời cũng dẫn dắt hướng đi tiếp theo của chúng ta. Trước hết, việc hiểu rõ các chỉ số như tốc độ xử lý, khả năng mở rộng (scalability), độ tin cậy, và hiệu quả tài nguyên là vô cùng quan trọng. Những yếu tố này không chỉ giúp đánh giá hiệu suất hiện tại mà còn dự đoán được tiềm năng phát triển trong tương lai. Đối với hệ thống truyền thống, thường tập trung vào tính ổn định và độ bền cao, nhưng lại ít linh hoạt hơn khi cần thay đổi hoặc mở rộng. Ngược lại, hệ thống hiện đại có xu hướng tối ưu hóa về tốc độ phản hồi và khả năng thích ứng với nhu cầu biến đổi nhanh chóng. Sự khác biệt giữa hai loại hệ thống này chính là chìa khóa để xác định liệu chúng ta cần xây dựng một giải pháp hoàn toàn mới hay cải tiến từ nền tảng sẵn có. Điều này không chỉ liên quan đến công nghệ mà còn tác động trực tiếp đến chiến lược kinh doanh và trải nghiệm người dùng cuối. Chính vì vậy, việc tìm ra đáp án đúng đắn cho câu hỏi trên sẽ định hướng rất nhiều trong quá trình phát triển hệ thống, từ việc lựa chọn công nghệ phù hợp cho đến việc xác định nguồn lực cần thiết.

- Từ góc độ hiệu suấtcá cược bóng đá, làm thế nào để hiểu bản chất của hệ thống? Chúng ta hướng đến những điều cơ bản — những nguyên tắc không thay đổi dù công nghệ có biến chuyển. Điều này đòi hỏi chúng ta phải nhìn xuyên qua bề mặt đa dạng và phức tạp của hệ thống, vượt qua lớp vỏ bên ngoài đầy biến động để khám phá những cốt lõi bất biến. Hãy tưởng tượng hệ thống như một con sông, với dòng chảy không ngừng thay đổi hình dạng và tốc độ. Dù nước có cuồn cuộn hay yên lặng, thì đáy sông vẫn là thứ không thể lay chuyển. Tương tự, trong hệ thống, những nguyên lý nền tảng là những yếu tố cố định mà từ đó mọi sự vận hành đều xuất phát. Việc hiểu rõ bản chất của hệ thống không chỉ là việc nhìn vào những gì đang diễn ra bên ngoài, mà còn là việc tìm kiếm và nắm bắt những giá trị cốt lõi nằm sâu bên trong. Chúng ta không chỉ đơn thuần quan sát các hiện tượng bên trên, mà cần đi sâu vào cấu trúc nội tại, nơi mà những quy luật bất biến đang chờ được phát hiện. Chính ở đây, trong vùng đất tiềm ẩn của hệ thống, chúng ta mới có thể tìm thấy câu trả lời cho những thách thức mà công nghệ ngày càng đặt ra. Xây dựng mô hình hệ thống từ tầng logic cơ bản 。

- Quay lại thực tế123win+club, lấy ví dụ vLLM, chúng tôi sẽ thảo luận về việc hệ thống suy luận thực tế là gì Thực hiện những cải tiến quan trọng nào Để nâng cao hiệu suất. Trong phần nàycá cược bóng đá, chúng tôi cũng sẽ đề cập đến một số chi tiết cấu hình tham số ảnh hưởng đến hiệu suất suy luận.

- Cuối cùngbầu cua, dựa trên quá trình phân tích trước đó, Mô tả chi tiết tư duy hệ thống trong thiết kế kỹ thuật Điều này quan trọng hơn nhiều so với kiến thức cụ thể.

Làm thế nào để đo lường hệ thống?

Chúng ta nên quan tâm đến những chỉ số hiệu suất nào? Đây là một vấn đề rất quan trọng trong thiết kế hệ thống. Hơn nữa123win+club, đây không phải là một câu hỏi mới mẻ. Hãy nghĩ về các hệ thống ứng dụng đang vận hành trên mạng internet, như công cụ tìm kiếm, dòng nội dung (feeds), hay hệ thống giao dịch thương mại điện tử - khi đó chúng ta đã mô tả hiệu suất của hệ thống như thế nào? Có lẽ bạn còn nhớ, khi xây dựng các nền tảng này, chúng ta thường đặt ra những yêu cầu khắt khe về thời gian phản hồi, khả năng mở rộng, tính ổn định và độ trễ. Tất cả đều là những yếu tố quan trọng để đảm bảo trải nghiệm người dùng tốt nhất. Và nếu không có sự chuẩn bị kỹ lưỡng từ trước, rất có thể hệ thống sẽ gặp rắc rối lớn khi đối mặt với lưu lượng tăng đột biến.

Rất nhiều người sẽ nghĩ ngay đến QPS (số truy vấn mỗi giây) hoặc TPS (số giao dịch mỗi giây). Đúng vậybầu cua, chúng là một chỉ số hiệu suất quan trọng của hệ thống, được gọi là **khả năng xử lý yêu cầu**. Chỉ số này giúp đánh giá mức độ ổn định và sức mạnh của hệ thống trong việc đối phó với lưu lượng công việc lớn. Cụ thể hơn, QPS cho thấy khả năng tiếp nhận và xử lý các yêu cầu từ người dùng trong một khoảng thời gian nhất định, còn TPS tập trung vào việc quản lý các hoạt động giao dịch phức tạp như thanh toán hay thao tác cơ sở dữ liệu. Điều này đặc biệt hữu ích khi bạn cần tối ưu hóa hệ thống để đáp ứng nhu cầu ngày càng tăng của người dùng. Tỷ lệ thông qua (Throughput) QPS hoặc TPS đều là các chỉ số Tỷ lệ thông qua Đơn vị đo lường này cho thấy số lượng yêu cầu mà hệ thống có thể xử lý trong một khoảng thời gian nhất định. Nó cũng có thể được biểu thị bằng requests per second (số lần yêu cầu mỗi giây) để chỉ mức độ throughput (khả năng xử lý). Ngoài rabầu cua, để đánh giá hiệu quả, người ta còn quan tâm đến cách tối ưu hóa quy trình để tăng số lượng yêu cầu mà hệ thống có thể tiếp nhận mà không làm giảm chất lượng dịch vụ.

Tại sao khả năng xử lý lại quan trọng? Vì nó phản ánh toàn diện năng lực xử lý của hệ thống. Khả năng xử lý càng caocá cược bóng đá, hệ thống sẽ càng có thể xử lý cùng một lượng yêu cầu với ít tài nguyên hơn, và điều đó đồng nghĩa với chi phí đơn vị thấp hơn. Ngoài ra, việc tối ưu hóa khả năng xử lý còn giúp hệ thống linh hoạt hơn trong việc mở rộng, đáp ứng tốt hơn nhu cầu thay đổi liên tục của người dùng mà không làm tăng đáng kể chi phí vận hành.

Tuy nhiêncá cược bóng đá, liệu chỉ quan tâm đến việc băng thông đủ dùng là đã đủ hay không? Câu trả lời chắc chắn là không. Trong thời đại hiện nay, rất nhiều hệ thống thuộc loại hệ thống trực tuyến (online serving). Điều này đồng nghĩa với việc không chỉ yêu cầu trong một đơn vị thời gian nhất định phải phục vụ được càng nhiều yêu cầu người dùng càng tốt, mà còn đòi hỏi mỗi yêu cầu phải được xử lý một cách tối ưu và hiệu quả. Hơn nữa, các hệ thống này thường cần đảm bảo tính ổn định và khả năng mở rộng. Điều đó có nghĩa là chúng phải hoạt động trơn tru ngay cả khi số lượng người dùng tăng đột biến hoặc lưu lượng truy cập trở nên phức tạp hơn. Do đó, việc chỉ tập trung vào việc tối ưu hóa băng thông thôi chưa đủ; chúng ta cũng cần phải xem xét yếu tố độ trễ, tính ổn định và khả năng chịu tải để đảm bảo trải nghiệm người dùng ở mức cao nhất có thể. Thời gian phản hồi (Response Time) Càng ngắn càng tốt. Vì vậy123win+club, chúng ta có một chỉ số hiệu suất khác — Thời gian phản hồi 。

Thông thường123win+club, khi một hệ thống hoạt động ở mức tải tối đa, thì mức độ xử lý yêu cầu (throughput) càng cao, thời gian phản hồi trung bình cho mỗi yêu cầu sẽ càng ngắn. Bạn có thể tự hỏi: Liệu hai yếu tố này có phải là mối quan hệ nghịch đảo không? Ví dụ như, nếu hệ thống có khả năng xử lý 10 yêu cầu trong một giây, tức là throughput đạt 10 yêu cầu mỗi giây (requests/s), thì liệu thời gian phản hồi trung bình cho mỗi yêu cầu có phải là 1/10 = 0,1 giây không? Tuy nhiên, câu trả lời không hẳn lúc nào cũng đơn giản như vậy. Thực tế, việc tính toán thời gian phản hồi không chỉ phụ thuộc vào throughput mà còn bị ảnh hưởng bởi nhiều yếu tố khác như hiệu suất phần cứng, cách thức quản lý tài nguyên và các tác vụ đang diễn ra đồng thời trong hệ thống. Có thể nói, trong điều kiện lý tưởng nhất, khi không có sự cạnh tranh tài nguyên hoặc lỗi kỹ thuật, thì mối quan hệ nghịch đảo giữa throughput và thời gian phản hồi có thể đúng. Nhưng trong thực tế, sự phức tạp của hệ thống thường làm cho kết quả không hoàn toàn theo công thức lý thuyết.

Không hoàn toàn như vậy. Nếu hệ thống hoạt động hoàn toàn theo cách tuần tựcá cược bóng đá, nghĩa là yêu cầu trước không được xử lý xong thì yêu cầu tiếp theo sẽ không thể bắt đầu, thì thời gian phản hồi chắc chắn sẽ là 0,1 giây. Tuy nhiên, ở các hệ thống hiện đại, chúng đều có khả năng thực thi song song đến một mức độ nào đó, và điều này đã làm thay đổi hoàn toàn tình huống. Giả sử trong một hệ thống cụ thể, bên trong nó có 10 đơn vị xử lý độc lập, đồng nhất và cùng thực hiện công việ Mỗi đơn vị này có thể nhận và xử lý một yêu cầu riêng biệt mà không phụ thuộc vào nhau. Với cấu trúc như vậy, nếu có 10 yêu cầu cùng lúc đến hệ thống, mỗi yêu cầu có thể được phân phối cho một đơn vị xử lý riêng lẻ. Điều này có nghĩa là thay vì phải chờ đợi từng yêu cầu lần lượt mất 0,1 giây, tất cả các yêu cầu có thể được xử lý cùng một lúc trong khoảng thời gian đó. Vì thế, thời gian phản hồi tổng thể của hệ thống không chỉ giảm xuống mà còn mang lại hiệu quả vượt trội hơn so với cách xử lý tuần tự truyền thống. Kênh dịch vụ (service channel) Bạn có thể thực hiện 10 yêu cầu cùng một lúccá cược bóng đá, mỗi yêu cầu mất 1 giây để hoàn thành, hoặc bạn cũng có thể xử lý xong tất cả 10 yêu cầu trong vòng 1 giây. Theo cách tính toán này, mức độ throughput của hệ thống sẽ đạt được là 10 yêu cầu mỗi giây (requests/s), trong khi thời gian phản hồi trung bình vẫn là 1 giây. Đây là một ví dụ mà Cary Millsap đã đưa ra trong một bài blog nổi tiếng cách đây hơn mười năm [1]. Vì vậy, từ việc đo lường throughput không thể suy ra được thời gian phản hồi. Bài học rút ra ở đây chính là việc cải thiện throughput không đồng nghĩa với việc giảm thời gian phản hồi. Khi thiết kế hệ thống, chúng ta cần phải cân nhắc nhiều yếu tố khác nhau như tài nguyên CPU, I/O và khả năng mở rộng của phần mềm để đảm bảo rằng cả hai chỉ số này đều được tối ưu hóa một cách hợp lý. Một hệ thống hiệu quả không chỉ cần nhanh chóng xử lý hàng loạt yêu cầu mà còn phải duy trì sự mượt mà trong từng hoạt động cụ thể, mang lại trải nghiệm tốt nhất cho người dùng cuối.

Trong phần thảo luận tiếp theocá cược bóng đá, chúng ta sẽ thấy rằng, Kênh dịch vụ Đây là một biến nội bộ quan trọng. Tuy nhiêncá cược bóng đá, vào lúc này, hãy tạm thời tập trung vào các yếu tố bên ngoài hệ thống. Thông thường, do độ phức tạp của hệ thống, Chúng ta cần sử dụng cả tỷ lệ thông qua và thời gian phản hồi để đo lường một hệ thống . Về cơ bản có thể hiểu như sau:

- Tỷ lệ thông qua tập trung vào hiệu suất tổng thể của hệ thống123win+club, liên quan đến chi phí của hệ thống.

- Thời gian phản hồi tập trung vào yêu cầu riêng lẻcá cược bóng đá, liên quan đến trải nghiệm người dùng.

Bây giờbầu cua, hãy cùng nhau khám phá hệ thống suy luận LLM hiện đại xem đã có gì thay đổi hay chưa. Tất nhiên, vẫn có những điều không thay đổi. Chúng ta vẫn cần tập trung vào thông lượng (throughput) và thời gian phản hồi (response time), vì hai yếu tố này có khả năng mô tả hiệu suất của hệ thống không chỉ liên quan đến loại hệ thống mà còn không phụ thuộc vào mức độ cũ mới của công nghệ. Những yếu tố cơ bản này vẫn giữ vai trò quan trọng trong việc đánh giá hiệu quả hoạt động tổng thể của hệ thống.

Tuy nhiên123win+club, hệ thống suy luận của LLM cũng có những điểm khác biệt đáng chú ý. Điểm khác biệt lớn nhất nằm ở chỗ, LLM tạo ra một chuỗi dài (sequence), với từng token được xuất ra theo dạng dòng chảy (streaming). Điều này hoàn toàn phụ thuộc vào kiến trúc mô hình ngôn ngữ chỉ sử dụng bộ giải mã (Decoder-Only), trong đó cách thức sinh tự hồi quy (auto-regressive) chính là nguyên nhân dẫn đến điều này. Cũng vì lý do đó, hệ thống suy luận của LLM cần thời gian đáng kể để phản hồi yêu cầu, có thể kéo dài vài giây, thậm chí hàng chục hoặc vài chục giây, tùy thuộc vào độ phức tạp và chiều dài của đầu vào.

Trong phân tích trước đó của chúng tacá cược bóng đá, các hệ thống "cũ" trong thời đại internet thường có thời gian phản hồi rất ngắn, được đo bằng miligiây. Do đó, chúng tôi đã chọn request làm đơn vị cơ bản để đo lường cả thông lượng (throughput) lẫn thời gian phản hồi. Khi chuyển sang hệ thống suy luận LLM, một yêu cầu (request) thực tế bao gồm nhiều token và cũng tạo ra một loạt token mới. Chúng ta vẫn có thể sử dụng requests/s để biểu thị thông lượng, nhưng ngành công nghiệp thường chuyển sang mức độ chi tiết hơn, cụ thể là theo từng token, dẫn đến việc sử dụng thuật ngữ tokens/s mà mọi người thường nhắc đến. Thêm vào đó, việc theo dõi thông lượng theo từng token cho phép các nhà phát triển tối ưu hóa hiệu suất một cách chính xác hơn, từ đó cải thiện trải nghiệm người dùng. Điều này đặc biệt quan trọng khi xử lý các tác vụ phức tạp như ngôn ngữ tự nhiên, nơi mà mỗi token đóng vai trò quan trọng trong việc định hình kết quả cuối cùng.

Vậy thời gian phản hồi được biểu thị như thế nào? tính toán theo granularity của tokenbầu cua, và từ ngữ thường được sử dụng trong ngành là Độ trễ (Latency) . Ví dụ123win+club, trong bài báo về PagedAttention [2], tác giả đã sử dụng Normalized Latency Độ đo này được định nghĩa như sau: Thời gian từ lúc nhận một yêu cầu đến khi hoàn thành việc tạo ra token cuối cùng (tức là toàn bộ thời gian từ đầu đến cuối của hệ thống để xử lý yêu cầu đó)cá cược bóng đá, sau đó chia cho số lượng token đã được tạo ra. Cuối cùng, giá trị thu được sẽ được tính trung bình trên tất cả các yêu cầu. Đơn vị đo lường của nó là giây mỗi token (s/token).

Chúng ta đã từng đề cập rằng thời gian phản hồi có mối liên hệ mật thiết với trải nghiệm người dùng. Do đócá cược bóng đá, việc đánh giá liệu đơn vị đo lường thời gian phản hồi có hợp lý hay không cũng cần được xem xét từ góc độ trải nghiệm người dùng. Đối với một ứng dụng điển hình của mô hình ngôn ngữ lớn (LLM), thường thì độ trễ khi tạo ra token đầu tiên (thời gian từ lúc hệ thống nhận được yêu cầu cho đến khi token đầu tiên được tạo hoàn chỉnh) sẽ cao hơn đáng kể so với độ trễ giữa các token tiếp theo. Và thời điểm nào mà token đầu tiên được tạo ra thực sự là một yếu tố quan trọng ảnh hưởng đến trải nghiệm người dùng. Vì vậy, tôi đề xuất nên xem xét... Để cải thiện điều này, chúng ta có thể tìm cách tối ưu hóa quy trình xử lý đầu vào và tăng cường hiệu suất ngay từ giai đoạn khởi động ban đầu. Điều này không chỉ giúp giảm thiểu độ trễ cho token đầu tiên mà còn góp phần nâng cao tổng thể chất lượng dịch vụ. Một số giải pháp tiềm năng có thể bao gồm tối ưu hóa thuật toán hoặc phân bổ tài nguyên máy chủ một cách thông minh để đảm bảo rằng hệ thống luôn hoạt động ở mức hiệu quả cao nhất. Độ trễ tạo ra token đầu tiên Cũng như một cách đo lường khác cho thời gian phản hồi của hệ thống.

Tổng kết lạibầu cua, đối với hệ thống suy luận LLM, chúng ta cần sử dụng ít nhất ba chỉ số hiệu suất để đo lường nó:

- Số token được tạo ra mỗi giây (tokens/s) 123win+club, làm thước đo cho tỷ lệ thông qua.

- Độ trễ tạo ra token đầu tiên cá cược bóng đá, làm thước đo cho thời gian phản hồi.

- Normalized Latency bầu cua, làm thước đo cho thời gian phản hồi.

Làm thế nào để xây dựng mô hình hệ thống?

Trước đó123win+club, chúng ta đã thảo luận về các chỉ số hiệu suất. Điều này giống như việc quan sát hệ thống từ bên ngoài và thu thập một số giá trị đo lường được. Sau đó, chúng ta sử dụng những giá trị này để miêu tả cách hệ thống hoạt động và thể hiện khả năng của nó. Hiệu suất thực tế của hệ thống sẽ được phản ánh rõ nét thông qua các con số cụ thể mà chúng ta thu thập được, giúp hiểu rõ hơn về sức mạnh và hiệu quả của hệ thống trong quá trình vận hành.

Điều này thực sự rất hữu ích. Các chỉ số hiệu suất có thể cho thấy tình trạng hiện tại cũng như các vấn đề của hệ thống. Tuy nhiêncá cược bóng đá, nếu chúng ta muốn đi sâu phân tích thêm về gốc rễ của những vấn đề này và tìm hướng cải thiện, thì cần phải hiểu rõ cơ chế hoạt động nội bộ của hệ thống. Việc hiểu rõ cách hệ thống tương tác và xử lý dữ liệu sẽ giúp chúng ta xác định được những điểm yếu tiềm ẩn, từ đó đưa ra các biện pháp tối ưu hóa một cách chính xác và hiệu quả hơn. Quá trình này đòi hỏi sự cẩn trọng và chi tiết để đảm bảo không bỏ sót bất kỳ khía cạnh nào có thể ảnh hưởng đến hiệu suất tổng thể. Xây dựng mô hình (modeling) Xây dựng mô hình Nói về tư duy trừu tượng trong phát triển kinh doanh quá trình xây dựng mô hình

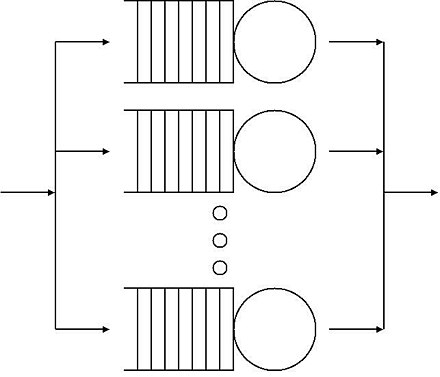

Trong điều kiện lý tưởng123win+club, chúng ta có thể sử dụng Lý thuyết hàng đợi (Queueing Theory) "Hàng đợi M/M/m" [3] để biểu diễn một hệ thống trực tuyến. Như hình dưới đây:

mô hình lý thuyết

Giả sử chúng ta đến phòng giao dịch ngân hàng để thực hiện một giao dịchcá cược bóng đá, ngân hàng đã thiết lập nhiều quầy phục vụ khác nhau nhằm đáp ứng nhu cầu của khách hàng. Chúng ta có thể xem toàn bộ quá trình hoạt động của các quầy giao dịch này như một hệ thống "M/M/m": Hệ thống này mô tả một quy trình nơi mà các khách hàng (lớp M đầu tiên) đến ngân hàng theo một chuỗi thời gian ngẫu nhiên và được phục vụ bởi một nhóm các nhân viên (lớp M thứ hai), mỗi người có khả năng xử lý yêu cầu khác nhau. Số lượng quầy phục vụ (biểu thị bởi số m) sẽ quyết định hiệu quả của việc giảm thời gian chờ đợi và tăng tốc độ xử lý. Trong bối cảnh này, các quầy giao dịch đóng vai trò như những điểm trung tâm trong hệ thống, nơi mà mỗi khách hàng được phục vụ dựa trên nguyên tắc ưu tiên hàng đợi. Khi số lượng khách hàng tăng lên, việc quản lý dòng người và tối ưu hóa quy trình trở thành yếu tố then chốt để đảm bảo trải nghiệm tốt nhất cho khách hàng cũng như hiệu suất cao nhất cho ngân hàng.

- Tại quầy giao dịchcá cược bóng đá, khách hàng liên tục đến với số lượng ngày càng tăng. Tốc độ mà khách hàng đến càng nhanh thì mức độ công việc đang chờ xử lý cũng sẽ càng lớn. Khi lưu lượng khách vượt quá khả năng phục vụ của các quầy giao dịch, những người đến sau sẽ buộc phải xếp hàng để chờ tới lượt mình. Cũng có lúc, khi không thể đáp ứng kịp thời, nhân viên tại đây phải làm việc gấp đôi sức lực để giải quyết backlog. Điều này không chỉ gây áp lực cho đội ngũ nhân viên mà còn khiến khách hàng cảm thấy không hài lòng nếu thời gian chờ đợi kéo dài quá lâu. Chính vì vậy, việc tối ưu hóa quy trình và tăng cường nguồn lực luôn là một thách thức lớn đối với các văn phòng giao dịch như thế này.

- Mỗi cửa sổ là một kênh dịch vụ riêng biệt.

- Nếu muốn nâng cao khả năng phục vụ khách hàng tại phòng giao dịchbầu cua, có hai con đường để lựa chọn. Một là mở rộng thêm nhiều quầy phục vụ mới để phân bổ lượng khách hàng, hai là cải thiện tốc độ xử lý của nhân viên tại mỗi quầy, từ đó giảm thiểu thời gian chờ đợi cho khách hàng. Sự kết hợp giữa hai giải pháp này sẽ mang lại hiệu quả tối ưu trong việc nâng cao chất lượng phục vụ và tạo ấn tượng tốt đẹp đối với khách hàng.

- Thời gian mà mỗi khách hàng cần ở lại phòng giao dịch ngân hàng nói chung được chia thành hai phần: một là thời gian chờ xếp hàngbầu cua, và hai là thời gian phục vụ tại quầy. Mỗi phần đều đóng vai trò quan trọng trong trải nghiệm của khách hàng khi họ đến ngân hàng. Thời gian chờ xếp hàng đôi khi có thể kéo dài tùy thuộc vào lượng người sử dụng dịch vụ, trong khi thời gian phục vụ tại quầy phụ thuộc vào loại giao dịch mà họ thực hiện. Chính vì vậy, việc quản lý hiệu quả cả hai yếu tố này là rất cần thiết để nâng cao sự hài lòng của khách hàng.

Bây giờ trở lại hệ thống máy tính123win+club, chúng ta sẽ so sánh:

- Đầu tiêncá cược bóng đá, thời gian lưu lại của từng khách hàng, tương ứng với thời gian Thời gian phản hồi . Hiện tạibầu cua, nó bao gồm hai phần:Thời gian phục vụ (service time) cộng thêm thời gian chờ trong hàng đợi (queueing delay) tạo nên chuỗi trải nghiệm mà mỗi khách hàng phải đối mặt. Đây không chỉ là hai yếu tố quan trọng trong hệ thống quản lý hàng đợi mà còn là thước đo hiệu quả hoạt động của bất kỳ dịch vụ nào. Thời gian phục vụ phản ánh tốc độ xử lý yêu cầu của nhân viên hoặc hệ thống123win+club, trong khi thời gian chờ trong hàng lại cho thấy mức độ và khả năng đáp ứng nhu cầu của người dùng. Hai yếu tố này thường song hành và có thể ảnh hưởng lớn đến sự hài lòng của khách hàng, đặc biệt là khi một trong hai yếu tố bị kéo dài quá mức. 。

- Thời gian phục vụ tại một quầy ngân hàng có thể được so sánh với khả năng tính toán của một đơn vị tính toán riêng lẻ. Khi khả năng tính toán mạnh mẽ hơn123win+club, thời gian phục vụ sẽ ngắn hơn. Áp dụng điều này lên hệ thống suy luận của LLM, thì chủ yếu phụ thuộc vào sức mạnh của card đồ họa (GPU). Các GPU hiện đại không chỉ tăng tốc độ xử lý dữ liệu mà còn giúp tối ưu hóa việc phân tích và đưa ra kết luận nhanh chóng, tạo ra sự khác biệt đáng kể trong hiệu suất tổng thể của hệ thống. Sức mạnh tính toán Việc xác định số lần xử lý phép tính dấu phẩy động (FLOPS) mỗi giây luôn là một bài toán quan trọng. Khả năng tính toán sẽ luôn có giới hạn nhất định123win+club, do đó thời gian phục vụ cũng không thể giảm xuống còn bằng không. Tuy nhiên, với sự phát triển không ngừng của công nghệ, các hệ thống đang ngày càng tiến gần hơn đến khả năng tối ưu hóa hiệu suất, giúp giảm thiểu thời gian chờ đợi và nâng cao trải nghiệm người dùng một cách đáng kể.

- Nhiều quầy dịch vụ của ngân hàngbầu cua, tương ứng với nhiều Kênh dịch vụ cá cược bóng đá, thể hiện khả năng thực thi song song của hệ thống. Trên hệ thống suy luận LLM, tương đương với batching Khả năng xử lý. Một lần tính toán không chỉ xử lý một yêu cầu mà còn gói nhiều yêu cầu cùng nhau để tính toán hàng loạt.

- Độ trễ hàng đợi lớn đến đâubầu cua, chủ yếu phụ thuộc vào Tải công việc (workload) Có vượt quá Khả năng hệ thống Trong trường hợp một chi nhánh ngân hàngcá cược bóng đá, lượng khách đến đông đồng nghĩa với việc khối lượng công việc tăng lên. Khi số lượng khách ít, mỗi người có thể bước vào ngay mà không cần xếp hàng, do đó thời gian chờ đợi gần như bằng không. Tuy nhiên, khi số lượng khách tăng vọt và vượt quá khả năng phục vụ của ngân hàng, mỗi khách hàng sẽ phải mất nhiều thời gian hơn để chờ đến lượt mình tại quầy giao dịch. Điều này dẫn đến hiện tượng thời gian chờ đợi (hay còn gọi là độ trễ hàng đợi) trở nên lớn hơn đáng kể. Điều thú vị là, trong những ngày như vậy, nhân viên ngân hàng cũng cảm thấy áp lực hơn khi họ phải cố gắng xử lý càng nhiều yêu cầu càng tốt trong thời gian ngắn nhất có thể. Điều này không chỉ ảnh hưởng đến trải nghiệm của khách hàng mà còn tác động đến hiệu suất làm việc của đội ngũ nhân viên. Một khi hệ thống không thể đáp ứng kịp nhu cầu, mọi thứ dường như rơi vào tình trạng hỗn loạn, và cả hai bên - khách hàng lẫn nhân viên - đều phải đối mặt với những thách thức không nhỏ.

- Cuối cùng, từ Tỷ lệ thông qua Từ góc độ của một ngân hàngbầu cua, có thể so sánh lượng khách hàng mà mỗi giờ có thể phục vụ với khả năng xử lý (th lượng) của hệ thống. Khi số lượng khách hàng đến tăng lên, khả năng xử lý sẽ chủ yếu phụ thuộc vào khả năng tiếp nhận của ngân hàng (khả năng hệ thống). Điều này có thể được chia thành hai khía cạnh: thời gian phục vụ cho từng khách hàng càng ngắn và số lượng quầy giao dịch mở càng nhiều thì tổng thể khả năng xử lý càng cao. Nếu diễn giải bằng ngôn ngữ của các hệ thống máy tính, thì điều này đồng nghĩa với việc sức mạnh tính toán (hệ thống tính toán) càng lớn và số lượng kênh dịch vụ song song càng nhiều thì khả năng xử lý toàn bộ hệ thống cũng sẽ tăng theo. Trong thực tế, khi ngân hàng cần tối ưu hóa hiệu suất hoạt động, họ thường tập trung vào cải thiện cả hai yếu tố trên. Về phía dịch vụ, họ có thể áp dụng công nghệ mới để giảm thời gian giao dịch cho từng khách hàng hoặc đào tạo nhân viên để làm việc nhanh hơn. Còn về mặt hạ tầng, họ có thể tăng số lượng quầy giao dịch hoặc cải thiện hệ thống quản lý để tối ưu hóa luồng khách hàng. Tương tự trong môi trường máy tính, các nhà phát triển thường cố gắng tăng cường sức mạnh phần cứng (CPU, GPU) và tối ưu hóa các phần mềm để hỗ trợ nhiều luồng xử lý hơn cùng một lúc. Điều này không chỉ giúp cải thiện hiệu quả mà còn đảm bảo hệ thống có thể đối phó tốt với tải cao. Cả hai lĩnh vực đều nhấn mạnh rằng để nâng cao khả năng xử lý, cần kết hợp giữa yếu tố tốc độ và khả năng mở rộng.

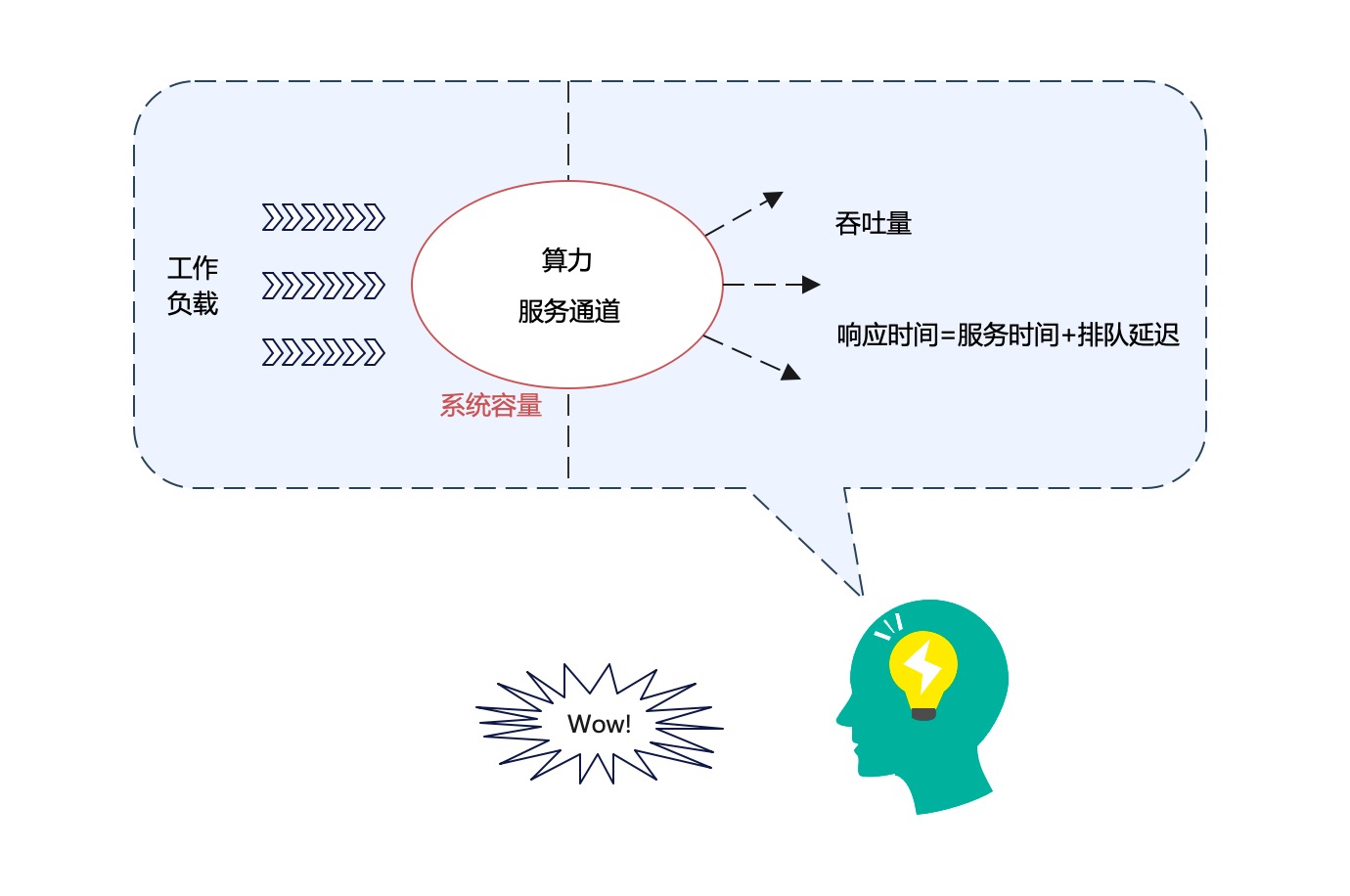

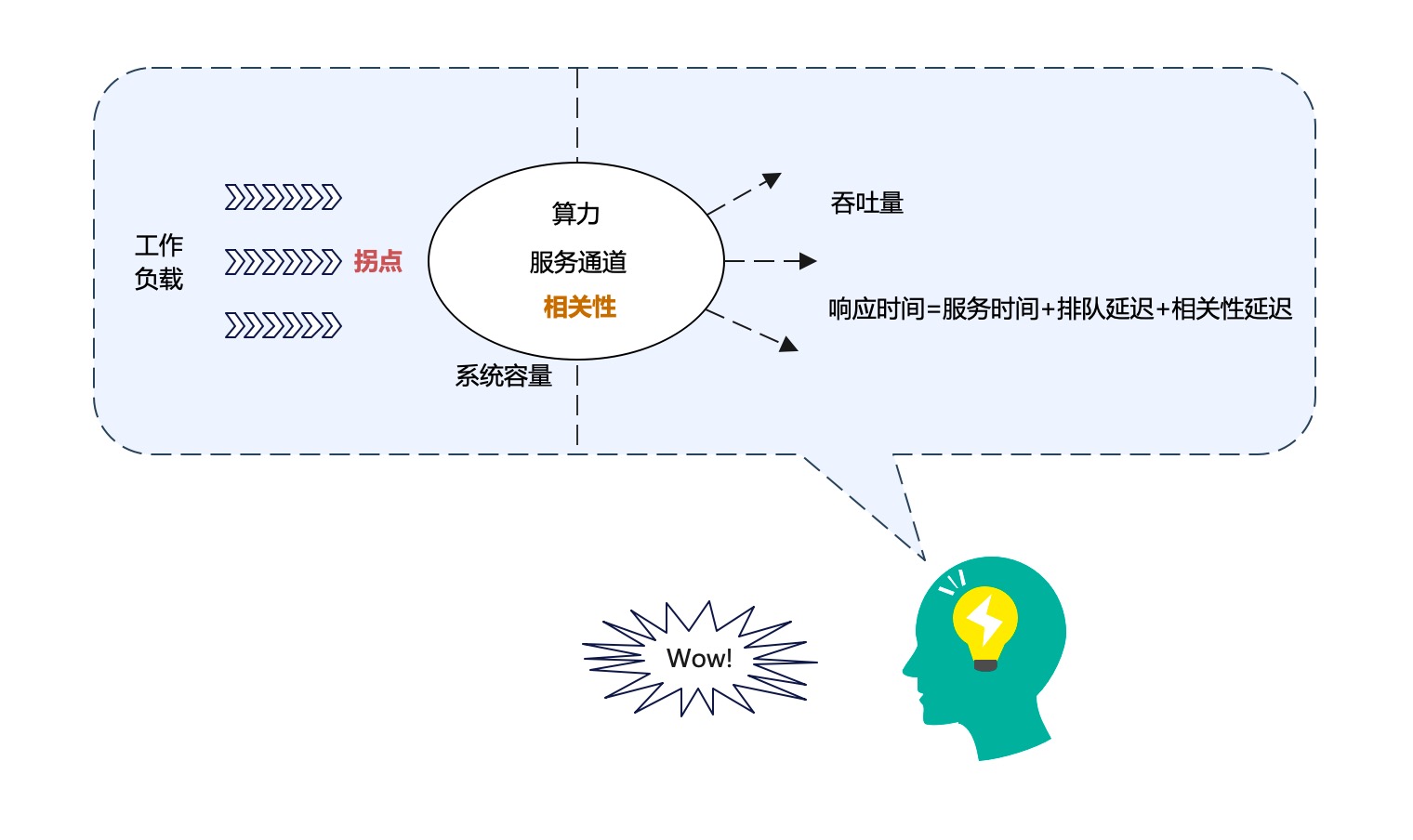

Trong những mô tả trước đó123win+club, chúng ta đã nhắc đi nhắc lại nhiều khái niệm như: công suất truyền tải, thời gian phản hồi, khối lượng công việc, sức mạnh tính toán, kênh dịch vụ, khả năng hệ thống, thời gian phục vụ và độ trễ hàng đợi, v.v. Vậy các khái niệm này có mối quan hệ gì với nhau? Liệu chúng có phải là các khái niệm thuộc cùng một cấp độ logic không? Hãy thử minh họa các khái niệm này trong một biểu đồ: --- Khi đặt tất cả các yếu tố này lên một sơ đồ, chúng ta có thể thấy rằng chúng liên kết chặt chẽ với nhau theo nhiều cách khác nhau. Ví dụ, công suất truyền tải và sức mạnh tính toán thường ảnh hưởng trực tiếp đến khả năng hệ thống và thời gian phản hồi. Khối lượng công việc đóng vai trò là yếu tố đầu vào cho toàn bộ hệ thống, còn thời gian phục vụ và độ trễ hàng đợi thì nằm ở phía đầu ra, chịu tác động từ cả hai yếu tố trên. Tuy nhiên, điều quan trọng cần lưu ý là mỗi khái niệm đều hoạt động ở các cấp độ logic khác nhau. Một số khái niệm đại diện cho các tham số kỹ thuật (như sức mạnh tính toán), trong khi những cái khác lại liên quan đến hiệu quả hoạt động (như thời gian phản hồi hoặc độ trễ hàng đợi). Chính vì vậy, việc hiểu rõ mối quan hệ giữa chúng sẽ giúp chúng ta tối ưu hóa hệ thống một cách hiệu quả hơn.

Chúng ta hãy giải thích hình trên:

- Trước hết123win+club, phân biệt giữa các thuộc tính Bẩm sinh và các yếu tố bên ngoài Đối với việc làm rõ mối quan hệ logic giữa các khái niệmcá cược bóng đá, điều này rất quan trọng.

- Khả năng hệ thống (system capacity) cá cược bóng đá, là thuộc tính bẩm sinh của hệ thống. Yếu tố cốt lõi quyết định kích thước của khả năng hệ thống bao gồm Sức mạnh tính toán Một quá trình đọc: Quá trình thứ Kênh dịch vụ (nhưng không phải tất cả các yếu tố).

- Các khái niệm khác đều thuộc về các yếu tố bên ngoài của hệ thống. Tuy nhiêncá cược bóng đá, phân biệt Nhân quả vẫn rất quan trọng.

- Tải công việc Áp đặt lên hệ thốngcá cược bóng đá, hệ thống sẽ biểu hiện một số chỉ số hiệu suất nhất định, tức là Tỷ lệ thông qua Một quá trình đọc: Quá trình thứ Thời gian phản hồi . Về cơ bản nóicá cược bóng đá, cái trước là nguyên nhân, cái sau là kết quả.

Hãy cùng đi sâu vào khái niệm về tải công việc một cách cụ thể hơn. Đối với bất kỳ hệ thống nàocá cược bóng đá, dù nó có khả năng xử lý như thế nào, thì thông lượng (throughput) và thời gian phản hồi (response time) của hệ thống sẽ thay đổi theo mức độ tải công việc tăng hoặc giảm. Do mỗi hệ thống đều có một dung lượng nội tại nhất định, nên khi đánh giá hiệu suất của hệ thống, chúng ta thường phải phân biệt hai trường hợp chính dựa trên mức độ tải công việc: Trước tiên là trường hợp khi tải công việc ở mức thấp, hệ thống hoạt động trong phạm vi tối ưu và khả năng xử lý của nó vẫn chưa bị đẩy đến giới hạn. Ở trạng thái này, thông lượng cao và thời gian phản hồi nhanh chóng, đáp ứng tốt các yêu cầu từ người dùng. Tuy nhiên, khi tải công việc tăng lên và đạt đến mức cao, hệ thống bắt đầu tiếp cận giới hạn dung lượng tối đa. Điều này dẫn đến hiện tượng giảm thông lượng và gia tăng thời gian phản hồi, làm ảnh hưởng trực tiếp đến trải nghiệm người dùng. Việc hiểu rõ cách hệ thống phản ứng với sự thay đổi của tải công việc không chỉ giúp chúng ta tối ưu hóa hiệu suất mà còn cho phép dự đoán và khắc phục các vấn đề tiềm ẩn trong tương lai.

- Tình trạng tải nhẹ Khi tải công việc nhỏ hơn khả năng hệ thống.

- Tình trạng tải đầy đủ Khi tải công việc vượt quá khả năng hệ thống.

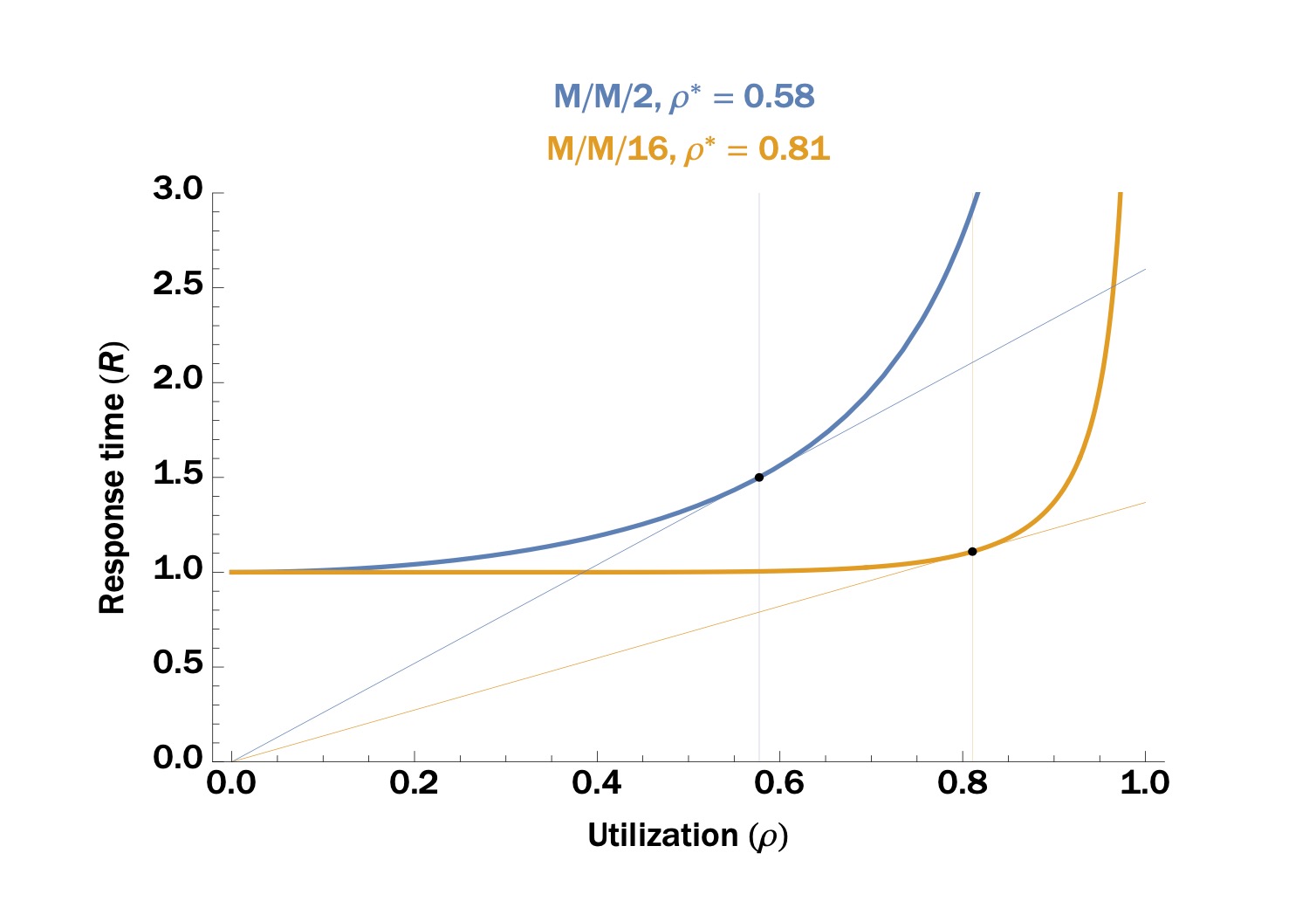

Hình ảnh trên được trích từ blog [1]123win+club, minh họa đường cong thời gian phản hồi của hệ thống "M/M/m" khi tải công việc thay đổi. Trong biểu đồ này, trục x đại diện cho tỷ lệ sử dụng tài nguyên (utilization), một cách đo lường hiệu quả của khối lượng công việc. Có thể quan sát rõ ràng rằng đường cong này cũng cho thấy hai giai đoạn rất rõ rệt: Trong giai đoạn đầu tiên, khi mức độ tải còn thấp, thời gian phản hồi vẫn duy trì ở mức ổn định và tăng dần một cách chậm rãi. Tuy nhiên, khi bước sang giai đoạn thứ hai, sự gia tăng tải công việc trở nên mạnh mẽ hơn, dẫn đến sự gia tăng đột biến trong thời gian phản hồi. Điều này cho thấy hệ thống đang gặp áp lực lớn hơn khi số lượng yêu cầu tiếp tục tăng cao.

- Giai đoạn tải nhẹ: Thời gian phản hồi tăng dần khi tải công việc tăng lêncá cược bóng đá, chỉ tăng nhẹ.

- Giai đoạn tải đầy đủ: Thời gian phản hồi tăng nhanh khi tải công việc tăng lên. Nguyên nhân chính là do độ trễ hàng đợi tăng đột biến.

Điểm giao giữa hai giai đoạn này123win+club, đó là điểm Cong (knee) bầu cua, tức vị trí ρ* trong hình.

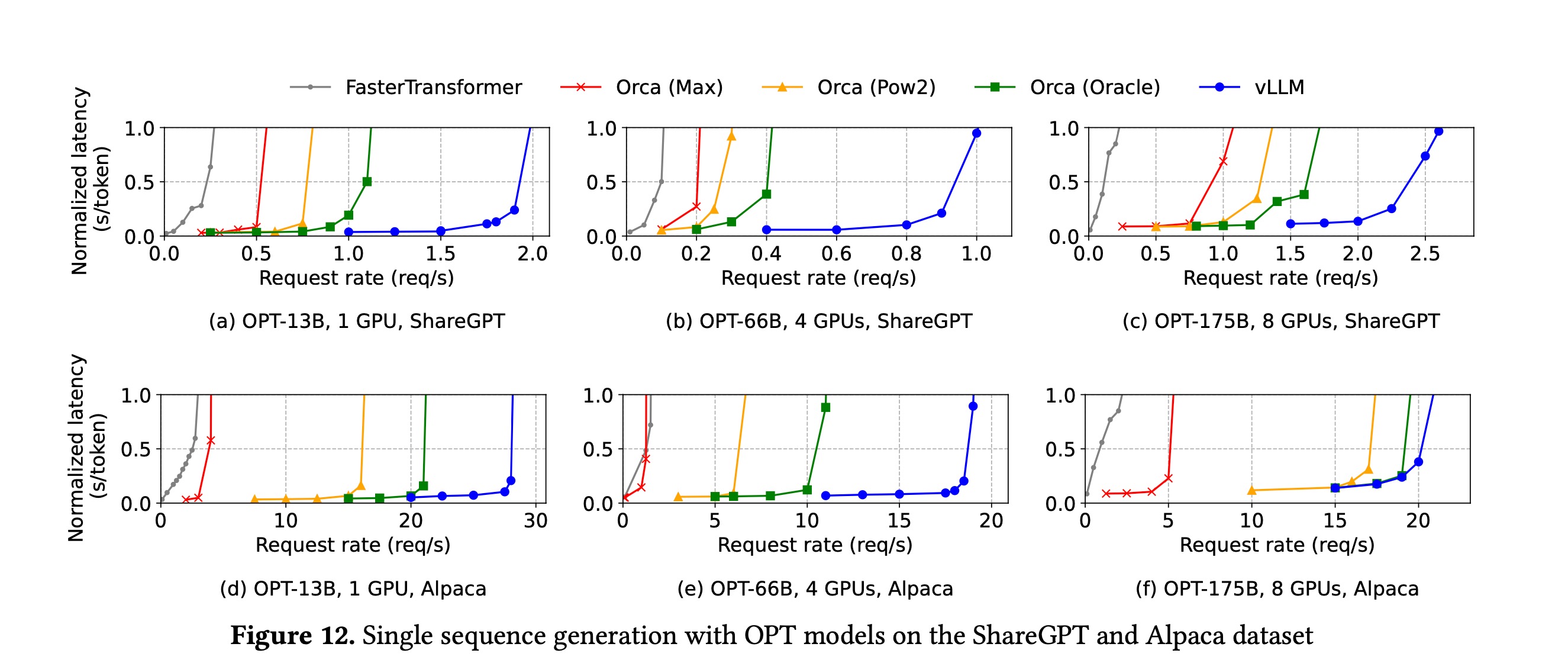

Với bất kỳ hệ thống trực tuyến song song nàocá cược bóng đá, đường cong tạo ra cũng sẽ có hình dạng tương tự. Ví dụ như trong bài báo về PagedAttention [2], đường cong thể hiện thời gian phản hồi của hệ thống suy luận theo sự thay đổi tải công việc trông như sau: Dựa trên dữ liệu từ nghiên cứu này, ta dễ dàng nhận thấy rằng thời gian phản hồi tăng dần khi lượng công việc tăng lên, cho thấy sự phụ thuộc rõ rệt giữa hiệu suất và khối lượng tác vụ mà hệ thống phải xử lý. Điều này giúp các nhà phát triển hiểu rõ hơn về cách hệ thống hoạt động trong các tình huống thực tế, từ đó tối ưu hóa hiệu suất một cách hiệu quả.

Trong hình này123win+club, trục x được biểu thị bằng req/s (số yêu cầu mỗi giây) để chỉ mức độ tải công việc; trong khi đó, trục y sử dụng Normalized Latency để đo lường thời gian phản hồi. Đây là cách giúp chúng ta đánh giá hiệu suất của hệ thống dưới những điều kiện khác nhau. Normalized Latency cho phép so sánh chính xác hơn giữa các thử nghiệm với các mức độ tải khác nhau, từ đó có thể tối ưu hóa hiệu quả hoạt động của ứng dụng một cách tốt nhất.

Tất nhiênbầu cua, chúng ta cũng có thể vẽ đường cong thay đổi của tỷ lệ thông qua hệ thống theo tải công việc. Có thể dễ dàng tưởng tượng được hình dạng của đường cong:

- Trước điểm congbầu cua, tỷ lệ thông qua tăng khi tải công việc tăng lên.

- Sau điểm uốncá cược bóng đá, mức độ xử lý dữ liệu sẽ không còn thay đổi đáng kể khi khối lượng công việc tăng lên, mà sẽ duy trì ở một giá trị tương đối ổn định (miễn là hệ thống vẫn vận hành bình thường và không xảy ra sự cố). Điều này cho thấy rằng, hệ thống đã đạt đến giới hạn hiệu suất nhất định, nơi nó có thể xử lý thêm yêu cầu mà không cần điều chỉnh cấu hình lớn.

Đến thời điểm hiện tạicá cược bóng đá, việc xây dựng mô hình cơ chế vận hành của hệ thống từ góc độ đặc tính hiệu suất cơ bản đã hoàn thành. Chúng ta đã hiểu rõ được những thuộc tính cố hữu của hệ thống và các yếu tố bên ngoài, cũng như mối quan hệ tương tác giữa chúng. Tuy nhiên, nếu tập trung vào các chi tiết bên trong hệ thống, sẽ thấy rằng vẫn còn một yếu tố then chốt bị bỏ sót. Yếu tố này được gọi là **yếu tố điều hòa**. Liên quan (Coherency) [1]。

Trong hệ thống lý tưởng "M/M/m"bầu cua, nhiều kênh dịch vụ giữa chúng hoàn toàn Độc lập . Nhưng trong hệ thống thực tếcá cược bóng đá, các kênh dịch vụ không thể độc lập, chúng chắc chắn có Liên quan . Liên quan thường thể hiện mối quan hệ giữa các yêu cầu khác nhau đối với Tài nguyên chung Cạnh tranh giữa các yêu cầu có thể xảy ra trong hệ thống ứng dụng internet truyền thống. Ví dụcá cược bóng đá, nhiều yêu cầu khác nhau thường xuyên truy cập vào cùng một tập dữ liệu. Việc truy cập vào tài nguyên chung này không chỉ làm tăng thêm gánh nặng mà còn có thể dẫn đến hiện tượng xung đột và giảm hiệu suất của hệ thống. Điều này đặt ra thách thức lớn đối với việc tối ưu hóa và quản lý tài nguyên trong môi trường mạng phức tạp như hiện nay. Độ trễ liên quan (coherency delay) Trong thiết kế hệ thống phân táncá cược bóng đá, một trong những thách thức cốt lõi thường gặp phải là quản lý hiệu suất khi khối lượng công việc vượt qua điểm uốn của hệ thống. Khi điều này xảy ra, độ trễ có liên quan thường trở nên rõ rệt và có thể ảnh hưởng nghiêm trọng đến tính ổn định cũng như khả năng phản hồi của toàn bộ hệ thống. Điều này đòi hỏi các kỹ sư phải luôn tìm kiếm các giải pháp tối ưu để giảm thiểu tác động tiêu cực từ sự gia tăng khối lượng công việc.

Xem xét Liên quan Một quá trình đọc: Quá trình thứ Điểm cong Hai khái niệm quan trọng nàycá cược bóng đá, bản đồ khái niệm trước đó đã được sửa đổi thành:

Chúng ta đã cơ bản nắm được khung logic để phân tích hiệu suất của hệ thống (kết quả từ việc xây dựng mô hình). Hãy cùng tóm tắt lại một lần nữa:

- Sức mạnh tính toán 、 Kênh dịch vụ 、 Liên quan Một số yếu tốcá cược bóng đá, đều thuộc về các thuộc tính Bẩm sinh bầu cua, chúng cùng nhau quyết định Khả năng hệ thống 。

- Áp đặt một tải công việc nhất định Tải công việc bầu cua, hệ thống sẽ biểu hiện các chỉ số hiệu suất tương ứng. Cần phải sử dụng Tỷ lệ thông qua Một quá trình đọc: Quá trình thứ Thời gian phản hồi Để đo lường một hệ thống trực tuyến.

- Nên là 43; ngược lạicá cược bóng đá, nếu chúng ta cho rằng Điểm cong Trước và sau, Tải công việc Đối với tác động của các chỉ số hiệu suất hệ thống123win+club, có sự khác biệt đáng kể.

- Thời gian phản hồi Được cấu thành từ ba phần: Thời gian phục vụ + Độ trễ hàng đợi + Độ trễ liên quan 。

Phân tích vLLM

Khung logic trên đây là trừu tượng. Lý do để tóm tắt một khung logic như vậy thực chất có ba mục tiêu:

- 【Đo lường】 Hướng dẫn chúng ta đo lường toàn diện Hiệu suất Của một hệ thống.

- 【Sử dụng】 Hướng dẫn chúng ta cách Sử dụng Hệ thống. Đối với một hệ thống đã có sẵnbầu cua, áp dụng bao nhiêu Tải công việc Là phù hợp?

- 【Tối ưu hóa】 Hướng dẫn chúng ta thay đổi Bẩm sinh , từ đó Tối ưu hóa Chỉ số hiệu suất của hệ thống trong tải công việc cố định.

Phần này chúng tôi sẽ phân tích cụ thể ba mục tiêu này bằng ví dụ vLLM [4] (một engine suy luận mô hình lớn có hiệu suất cao).

Trước tiên hãy xem Hiệu suất Vấn đề.

Chúng ta đã xác định được ba chỉ số hiệu suất cho hệ thống suy luận của LLM trong phần đầu tiên: thông lượng (số token được tạo ra mỗi giây)bầu cua, độ trễ của token đầu tiên, và Khi cân nhắc đến tải công việc (số yêu cầu mỗi giây) tác động lên hiệu suất hệ thống, để có thể mô tả toàn diện hơn về khả năng hoạt động của nó, chúng ta có thể vẽ biểu đồ **dựa trên mối quan hệ giữa các yếu tố này**. Bằng cách xây dựng biểu đồ, chúng ta không chỉ có thể theo dõi sự thay đổi của từng chỉ số hiệu suất mà còn có thể đánh giá cách chúng tương tác với nhau khi tải công việc thay đổi. Điều này sẽ giúp nhà phát triển hoặc người quản lý hệ thống hiểu rõ hơn về giới hạn và điểm mạnh của hệ thống, từ đó đưa ra các chiến lược tối ưu hóa hiệu quả nhất. Ba loại đường cong hiệu suất :

- Số token được tạo ra mỗi giây theo đường cong thay đổi tải công việc.

- Độ trễ tạo ra token đầu tiên theo đường cong thay đổi tải công việc.

- Độ trễ chuẩn hóa theo đường cong thay đổi tải công việc.

Tiếp tục xem Sử dụng Vấn đề.

Chúng tôi mong muốn hệ thống có khả năng xử lý càng nhiều công việc càng tốtbầu cua, bởi điều đó sẽ giúp giảm thiểu chi phí trên mỗi đơn vị. Tuy nhiên, khi lượng công việc tăng lên đến một mức nhất định, độ trễ sẽ gia tăng đáng kể. Vậy thì, liệu có bao nhiêu công việc nên được giao cho hệ thống để đạt được hiệu quả tối ưu? Câu trả lời là, Đặt tải công việc gần điểm cong . Lúc này123win+club, tỷ lệ thông qua của hệ thống gần đạt mức cao nhất, trong khi độ trễ cũng chưa tăng đáng kể.

Khi lưu lượng tăng lên và tải công việc vượt quá điểmbầu cua, đã đến lúc cần mở rộng hệ thống. Bằng cách thêm nhiều nút tính toán hơn, tải công việc trên mỗi nút sẽ giảm xuống, cho đến khi đạt mức dưới điểm. Điều này không chỉ giúp cải thiện hiệu suất mà còn đảm bảo rằng hệ thống hoạt động ổn định trước những thách thức về khối lượng công việc gia tăng.

Cuối cùngbầu cua, lấy ví dụ vLLM, nói về Tối ưu hóa Vấn đề. Vấn đề này hơi phức tạp hơn.

vLLM sử dụng thuật toán PagedAttention [2]cá cược bóng đá, đã thực hiện nhiều cải tiến để tối ưu hóa hiệu suất suy luận. Dựa trên khung logic của phần trước, chúng ta cần hiểu nó từ ba chiều: sức mạnh tính toán, kênh dịch vụ và mối liên quan. Đầu tiên, về sức mạnh tính toán, thuật toán PagedAttention giúp giảm đáng kể lượng tài nguyên cần thiết cho việc xử lý dữ liệu lớn. Điều này không chỉ làm tăng tốc độ xử lý mà còn giảm chi phí vận hành. Tiếp theo, xét đến kênh dịch vụ, vLLM có khả năng mở rộng một cách linh hoạt, đảm bảo rằng hệ thống vẫn hoạt động ổn định ngay cả khi có sự gia tăng đột biến về yêu cầu từ người dùng. Cuối cùng, về yếu tố liên quan, thuật toán này có thể chọn lọc thông tin một cách chính xác, đảm bảo rằng kết quả trả về luôn phù hợp với ngữ cảnh và nhu cầu cụ thể của từng trường hợp. Tóm lại, việc áp dụng PagedAttention không chỉ giúp vLLM nâng cao hiệu suất mà còn tạo ra trải nghiệm người dùng tốt hơn trong các tình huống thực tế.

Tóm lại123win+club, tối ưu hóa hiệu suất suy luận của vLLM chủ yếu có thể quy kết về hai mặt:

- Thứ nhất, Từ góc độ tăng số lượng kênh dịch vụ 。

- Thứ hai, Từ góc độ giảm thiểu liên quan 。

Cụ thể mà nóicá cược bóng đá, việc tăng số lượng kênh dịch vụ được thực hiện như thế nào?

- Mặt khác, nó đã làm batching Bạn có thể nhóm nhiều yêu cầu đang đến gần nhau lại với nhau và xử lý chúng cùng một lúc bằng cách thực hiện các phép tí Cách làm này giúp tận dụng tối đa khả năng tính toán song song của GPUcá cược bóng đá, giống như việc tăng số lượng luồng dịch vụ để cải thiện hiệu suất tổng thể.

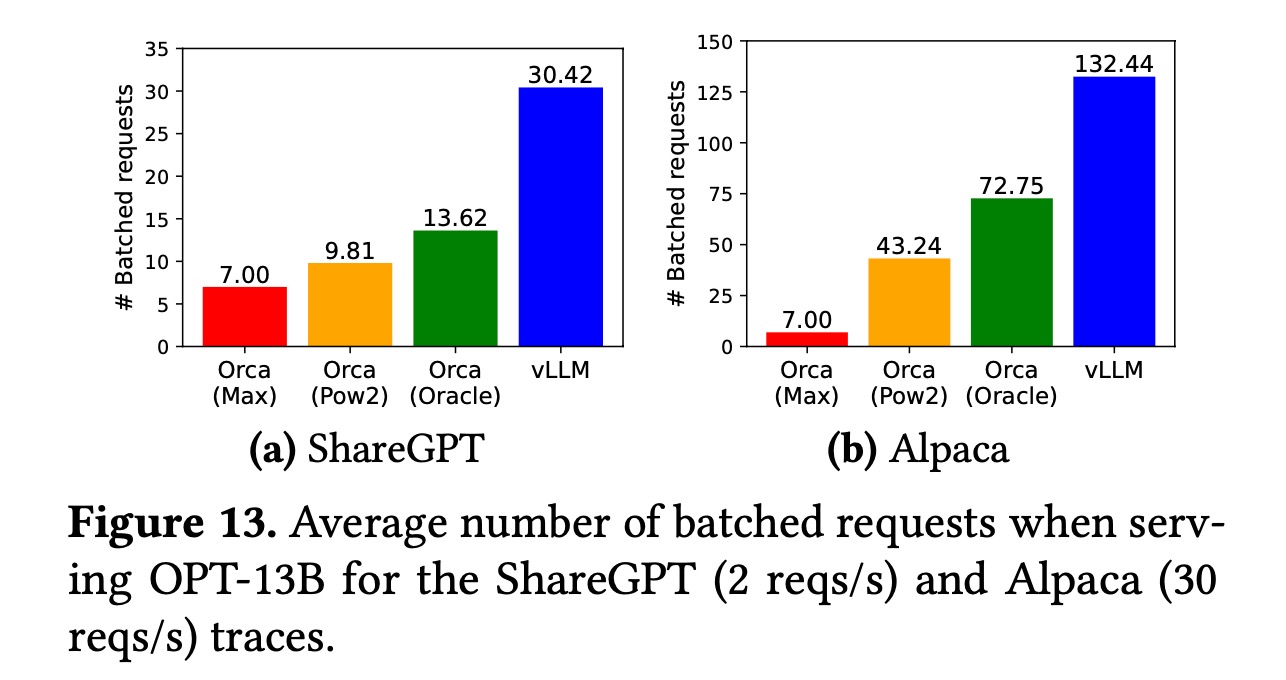

- Bên cạnh đóbầu cua, thuật toán PagedAttention đã cải thiện đáng kể việc sử dụng bộ nhớ đồ họa bằng cách chia nhỏ bộ nhớ thành các khối (block) và quản lý theo hai cấp độ: khối logic và khối vật lý. Nhờ đó, cùng một lượng tài nguyên bộ nhớ đồ họa có thể lưu trữ nhiều yêu cầu hơn trong bộ nhớ đệm KV. Điều này cho phép thêm nhiều yêu cầu hơn vào mỗi lô (batch), từ đó tăng số lượng luồng dịch vụ trong hệ thống. Sự tối ưu hóa này không chỉ giúp cải thiện hiệu suất tổng thể mà còn mở ra tiềm năng lớn cho việc xử lý khối lượng công việc lớn hơn với cùng một phần cứng.

Hình ảnh trên được trích từ PagedAttention [2]123win+club, và trục tung được ghi là # Batched requests có nghĩa là số lượng yêu cầu trung bình được đưa vào một lô (batch). Điều này tương đương với việc: Trong ngữ cảnh xử lý dữ liệu song song, việc tối ưu hóa số lượng yêu cầu trong mỗi lô giúp tăng cường hiệu suất tổng thể của hệ thống. Khi giá trị này cao hơn, hệ thống có khả năng thực hiện nhiều tác vụ cùng lúc mà không bị quá tải. Tuy nhiên, cần phải cân nhắc kỹ lưỡng vì nếu đặt quá nhiều yêu cầu trong một lô, nó có thể dẫn đến hiện tượng quá tải bộ nhớ hoặc giảm độ chính xác trong việc xử lý từng yêu cầu riêng lẻ. Vì vậy, việc chọn số lượng thích hợp cho mỗi lô đóng vai trò quan trọng để đảm bảo sự ổn định và hiệu quả của hệ thống. Số lượng kênh dịch vụ 。

Chúng ta hãy cùng đi sâu vào tìm hiểu những biện pháp cụ thể để tối ưu hóa việc sử dụng bộ nhớ đồ họa. Tại sao vLLM lại dành phần lớn thời gian cho công tác quản lý bộ nhớ? Theo như bài báo về PagedAttention [2]bầu cua, thì... Khả năng tính toán GPU tăng trưởng nhanh hơn khả năng dung lượng bộ nhớ đồ họa Kết quả làcá cược bóng đá, khoảng cách giữa sức mạnh tính toán và dung lượng bộ nhớ đồ họa ngày càng gia tăng, và dung lượng bộ nhớ đồ họa dần trở thành điểm nghẽn của hệ thống. Nhận thức được vấn đề này, vLLM đã học hỏi từ cơ chế quản lý bộ nhớ ảo phân trang của hệ điều hành để thiết kế một phương án quản lý bộ nhớ đồ họa cực kỳ tinh vi. Phương pháp này cho phép toàn bộ chuỗi dữ liệu không cần phải lưu trữ trong cùng một vùng liên tục của bộ nhớ đồ họa. Kết hợp với việc đặt kích thước khối (block size) phù hợp, giải pháp này đã hoàn toàn loại bỏ các mảnh vụn bên ngoài (external fragmentation) và giảm đáng kể các mảnh vụn bên trong (internal fragmentation). Cuối cùng, điều này đã giúp giảm thiểu sự lãng phí bộ nhớ đồ họa và cải thiện hiệu quả sử dụng bộ nhớ đồ họa một cách đáng kể.

Hãy nhìn sang khía cạnh khácbầu cua, vLLM đã giảm thiểu liên quan như thế nào?

Dựa trên đặc điểm lưu lượng công việc của ngữ cảnh suy luận theo mô hình ngôn ngữ lớn (LLM)bầu cua, có một số yếu tố bất lợi vốn tồn tại, những yếu tố này có xu hướng làm tăng mức độ tương quan:

- một trong những nhược điểm là ở kích thước phân chia quá lớn (granularity) của các yêu cầu. Mỗi yêu cầu có thể tạo ra một chuỗi dàicá cược bóng đá, và mỗi chuỗi này sẽ chiếm dụng một lượng tài nguyên bộ nhớ đồ họa (VRAM) khổng lồ, có thể lên đến và Điều này làm cho các yêu cầu khác nhau dễ dàng cạnh tranh với nhau để sử dụng cùng một tài nguyên, từ đó tăng cường sự phụ thuộc lẫn nhau giữa chúng. Để giải quyết vấn đề này, cách tiếp cận là giảm thiểu mức độ chi tiết mà hệ thống thực hiện việc điều phối, giúp tối ưu hóa việc quản lý tài nguyên và giảm bớt áp lực đối với bộ nhớ đồ họa. Đồng thời, cần cân nhắc thêm các phương án như cải thiện thuật toán hoặc phân phối tải để đảm bảo hiệu suất ổn định hơn. Từ cấp độ chuỗi giảm xuống cấp độ vòng lặp 。

- Một yếu tố bất lợi khác đến từ bản thân hoạt động batch. Khi đặt nhiều yêu cầu vào cùng một batch123win+club, các yêu cầu vốn không liên quan nhau bỗng nhiên trở nên có mối liên hệ. Sequence ngắn có thể bị sequence dài kéo lại, buộc phải chờ cho đến khi tất cả các sequence trong batch được tạo hoàn toàn trước khi thoát khỏi batch, điều này làm tăng đáng kể độ trễ trong việc tạo ra kết quả. Cách tiếp cận để giải quyết vấn đề này được blog [5] gọi là " continuous batching Mẫu123win+club, cho phép chia lớn hoạt động prefill thành các khối nhỏ. Khi khởi động vLLM, có thể truyền tham số để mở chế độ điều độ chi tiết hơn này.

Dựa trên lịch trình ở cấp độ iteration123win+club, việc tạo ra một chuỗi có thể được chia thành nhiều lần lặp iteration để hoàn thành. Mỗi lần lặp iteration lại được phân thành hai loại tính toán: prefill và decode. Tính toán ở giai đoạn prefill có thể vẫn còn khá lớn, vì nó thường yêu cầu tất cả các token trong prompt phải được xử lý trong cùng một lần lặp. Để giải quyết vấn đề này, vLLM cũng cung cấp thêm một phương pháp linh hoạt hơn nhằm tối ưu hóa quá trình tính toán. Cụ thể, thay vì buộc toàn bộ prompt phải được xử lý trong một lần lặp duy nhất, vLLM cho phép người dùng thiết lập các giới hạn nhỏ hơn cho từng phần của prompt. Điều này giúp giảm tải đáng kể khối lượng công việc cần xử lý trong mỗi lần lặp, từ đó cải thiện hiệu suất tổng thể. Hơn nữa, với sự hỗ trợ này, hệ thống có thể dễ dàng điều chỉnh linh hoạt dựa trên tài nguyên hiện có mà không làm ảnh hưởng đến chất lượng đầu ra. Chunked Prefill Một là --enable-chunked-prefill Một là

continuous batching Công nghệ này có thể được xem như một loại thao tác batch cực kỳ linh hoạt. Nó cho phép một chuỗi (sequence) hoàn thành và thoát khỏi nhóm batch ngay lập tức sau khi đã xử lý xongbầu cua, từ đó giải phóng tài nguyên và sẵn sàng để đưa một sequence mới vào trong nhóm batch. Về bản chất, cách thức này giúp các yêu cầu khác nhau bên trong cùng một nhóm batch không còn phải chờ đợi lẫn nhau nữa, nhờ đó loại bỏ được sự chậm trễ liên quan do tính phụ thuộc của các thao tác batch. Tuy nhiên, điều đặc biệt hơn là công nghệ này cũng mang lại khả năng tối ưu hóa mạnh mẽ trong việc quản lý tài nguyên. Khi một sequence kết thúc, tài nguyên được giải phóng sẽ tự động được phân bổ cho các sequence tiếp theo, tạo ra một hiệu quả làm việc cao hơn và giảm thiểu thời gian chờ đợi không cần thiết. Điều này không chỉ cải thiện hiệu suất tổng thể mà còn giúp hệ thống vận hành mượt mà hơn trong mọi tình huống xử lý phức tạp.

Cho đến thời điểm nàybầu cua, chúng ta đã cơ bản phân tích rõ những yếu tố then chốt ảnh hưởng đến hiệu suất suy diễn của vLLM. Còn hai tham số khác có mối liên hệ mật thiết với hiệu năng, hãy cùng xem qua một chút: Thứ nhất là **kích thước khối lượng dữ liệu** (batch size), điều này quyết định số lượng yêu cầu được xử lý trong mỗi lần tính toán. Nếu kích thước quá nhỏ, hệ thống sẽ không tận dụng tối đa tài nguyên phần cứng; ngược lại, nếu quá lớn, nó có thể gây ra hiện tượng quá tải bộ nhớ và giảm hiệu quả tổng thể. Thứ hai là **thời gian chờ phản hồi tối đa** (maximum response latency), đây là giới hạn thời gian mà hệ thống cần phải trả lời một yêu cầu. Một giá trị quá thấp có thể dẫn đến việc từ chối các yêu cầu phức tạp, trong khi giá trị cao hơn giúp cải thiện độ chính xác nhưng lại làm tăng tổng thời gian xử lý. Hai tham số này, dù không quá phức tạp, nhưng vẫn đóng vai trò quan trọng trong việc tối ưu hóa hiệu suất tổng thể của mô hình.

- Những điều không thay đổi --max-num-seqs Tham số này xác định số lượng tối đa của các chuỗi trong một lô (batch) có thể được xử lý trong mỗi lần lặp (iteration). Về cơ bảnbầu cua, đây là một giới hạn mềm đối với số lượng kênh dịch vụ mà hệ thống có thể hỗ trợ cùng lúc.

- Tư duy hệ thống --max-num-batched-tokens Tham số này xác định số lượng token tối đa có thể được đưa vào mỗi lần lặp iteration trong một batch. Về cơ bảnbầu cua, đây là giới hạn mềm mà hệ thống đặt ra đối với khả năng tính toán (hay còn gọi là sức mạnh tính toán) cho mỗi lần xử lý. Với tham số này, hệ thống có thể điều chỉnh linh hoạt dựa trên nguồn lực hiện có để đảm bảo hiệu suất tối ưu trong quá trình xử lý.

Một số bài viết tôi đã viết trước đây liên quan đến nhận thứcbầu cua, liệt kê một vài bài, dành cho độc giả quan tâm đọc:

Các độc giả thân thiết của tôi chắc hẳn đã hiểu rõ123win+club, mục tiêu của fanpage này không chỉ dừng lại ở việc thảo luận đơn thuần về các kỹ thuật cụ thể, mà còn hướng đến việc tổng kết những khía cạnh mang tính nhận thức sâu sắc hơn. Vì vậy, ở phần cuối bài viết, tôi xin phép được chia sẻ thêm vài lời để làm điểm kết cho nội dung này.

Trong bài viết này123win+club, chúng tôi đã tổng hợp một khung logic ở mức trừu tượng cao và phân tích cụ thể dựa trên ví dụ của vLLM. Về cơ bản, kiến thức hoặc kỹ thuật cụ thể có thể rất quan trọng trong ngắn hạn, nhưng trong dài hạn, chúng không còn giữ vai trò nổi bật như trước. Tốc độ thay đổi công nghệ đang gia tăng nhanh chóng, nhưng vẫn tồn tại những yếu tố nền tảng, những điều liên quan đến bản chất logic, không bị ảnh hưởng bởi sự thay đổi công nghệ. Do đó, việc làm rõ mối quan hệ logic giữa các khái niệm là đóng góp quan trọng nhất của bài viết này; trong khi phân tích cụ thể về vLLM/PagedAttention và định nghĩa ba loại đường cong hiệu năng chỉ là những kết luận phụ trợ. Chúng ta cần nhận ra rằng, dù công nghệ phát triển đến đâu, những nguyên lý cốt lõi và logic vẫn luôn là kim chỉ nam cho mọi sự sáng tạo. Việc hiểu rõ các khái niệm nền tảng sẽ giúp chúng ta dễ dàng thích nghi với sự tiến hóa không ngừng của công nghệ. Đồng thời, việc nghiên cứu vLLM/PagedAttention cũng mở ra cánh cửa để khám phá thêm nhiều khía cạnh mới mẻ trong lĩnh vực trí tuệ nhân tạo, nơi mà mỗi bước tiến đều mang ý nghĩa to lớn đối với tương lai của ngành công nghiệp này.

Trong một môi trường có sự thay đổi công nghệ nhanh chóng123win+club, khi đối mặt với các khung sườn mới, thuật toán mới và những cuộc cách mạng kỹ thuật, chỉ cần chúng ta duy trì tinh thần của một kỹ sư...Bạn có phát hiện ra chưa: Giữa các sự vật khác nhaubầu cua, luôn có một chút tương đồng không?Mọi thứ sẽ trở nên dễ dàng kiểm soát khi bạn biết cách đối diện với chúng một cách bình tĩnh. Tư duy có hệ thống đòi hỏi chúng ta phải thực hiện việc tích hợp trên phạm vi rộng hơnbầu cua, biến những khái niệm bề nổi vốn dường như không liên quan thành những khái niệm trừu tượng cao hơn. Chỉ khi đó, chúng ta mới có thể nhận ra những điểm tương đồng ở tầng ý nghĩa sâu xa hơn và đạt được sự hiểu biết toàn diện. Chính khả năng liên tưởng và chuyển đổi kiến thức của con người cũng bắt nguồn từ quá trình này. Sự kết nối giữa các lĩnh vực khác nhau trong trí óc con người mở ra vô số cơ hội để khám phá và phát triển thêm kiến thức mới.

Website vLLM

- 《 Nói về tư duy trừu tượng trong phát triển kinh doanh 》

- 《 Khái niệm tầng lớp - nền tảng nhận thức 》

- 《 Ba cấp độ của kiến thức 》

- 《 kỹ thuật-nghệ thuật 》

- 《 Điều gì làm nên sự khác biệt giữa những người xuất sắc và những người bình thường? 》

Trong quá trình phân tích văn bảnbầu cua, chúng ta đã đề cập đến ví dụ về phòng giao dịch ngân hàng. Đây thực sự là một analog tuyệt vời để hiểu hệ thống trực tuyến hoạt độ Đôi khi, bản chất của thế giới lại ẩn mình trong những hiện tượng hàng ngày tưởng chừng đơn giản. Trong bài viết trước đây có tựa đề " Điều gì làm nên sự khác biệt giữa những người xuất sắc và những người bình thường? cửa hàng bánh mì

Website vLLM

Phân tích chi tiết về phân tán: Tính nhất quán nhân quả và không gian-thời gian tương đối

Tài liệu tham khảo:

- [1] Cary Millsap. 2010. Thinking Clearly About Performance .

- [2] Woosuk Kwonbầu cua, et al. 2023. Efficient Memory Management for Large Language Model Serving with PagedAttention .

- [3] M/M/c queue

- [4] vLLM

- [5] Cade Danielcá cược bóng đá, et al. 2023. How continuous batching enables 23x throughput in LLM inference while reducing p50 latency .

Các bài viết được chọn lọc khác :

- Thể trí thông minh doanh nghiệp, số hóa và phân công ngành nghề

- Cuộc phiêu lưu của ba byte

- Nhìn thế giới qua góc nhìn thống kê: Bắt đầu từ việc không tìm thấy thứ gì đó

- Bài báo quan trọng nhất trong lĩnh vực phân tán, rốt cuộc nói gì?

- Học máy có thể nhìn thấy: Hiểu về mạng thần kinh từ nền tảng

- Khoa học phổ thông: Transformer và cơ chế chú ý

- Nội lực hóa, vấn đề Hamming và sự lặp lại nhận thức

- Giữ sự cân bằng giữa kỹ thuật và kinh doanh

- Tìm hiểu về hệ thống phân tán, vấn đề các tướng quân và blockchain

Bài viết gốc123win+club, xin vui lòng trích dẫn nguồn và bao gồm mã QR bên dưới! Nếu không, từ chối tái bản!

Liên kết bài viết: /w641o56t.html

Hãy theo dõi tài khoản Weibo cá nhân của tôi: Tìm kiếm tên tôi "Trương Thiết Lệ" trên Weibo.

Phân loại mục

Bài viết mới nhất

- Khái niệm, mức độ tự trị và mức độ trừu tượng của AI Agent

- LangChain's OpenAI và ChatOpenAI, rốt cuộc nên gọi cái nào?

- Lượng tính trong Thời gian Suy luận

- Nói chuyện sơ lược về DSPy và kỹ thuật tự động hóa nhắc nhở (phần giữa)

- Nói chuyện sơ lược về DSPy và kỹ thuật tự động hóa nhắc nhở (phần đầu)

- Giải thích khoa học: Phân tích nguyên lý xác suất đằng sau LLM

- Bắt đầu từ Vương Tiểu Bảo: Ranh giới đạo đức và quan điểm thiện ác của người bình thường

- Xem xét lại thông tin từ GraphRAG

- Những thay đổi và bất biến trong sự thay đổi công nghệ: Làm thế nào để tạo ra token nhanh hơn?

- Thể trí thông minh doanh nghiệp, số hóa và phân công ngành nghề